박재식 교수 연구진, 이미지 한 장에서 역동적인 자세를 취한 사람을 3D로 복원하기 위한 ‘DrPose’ 기법 개발

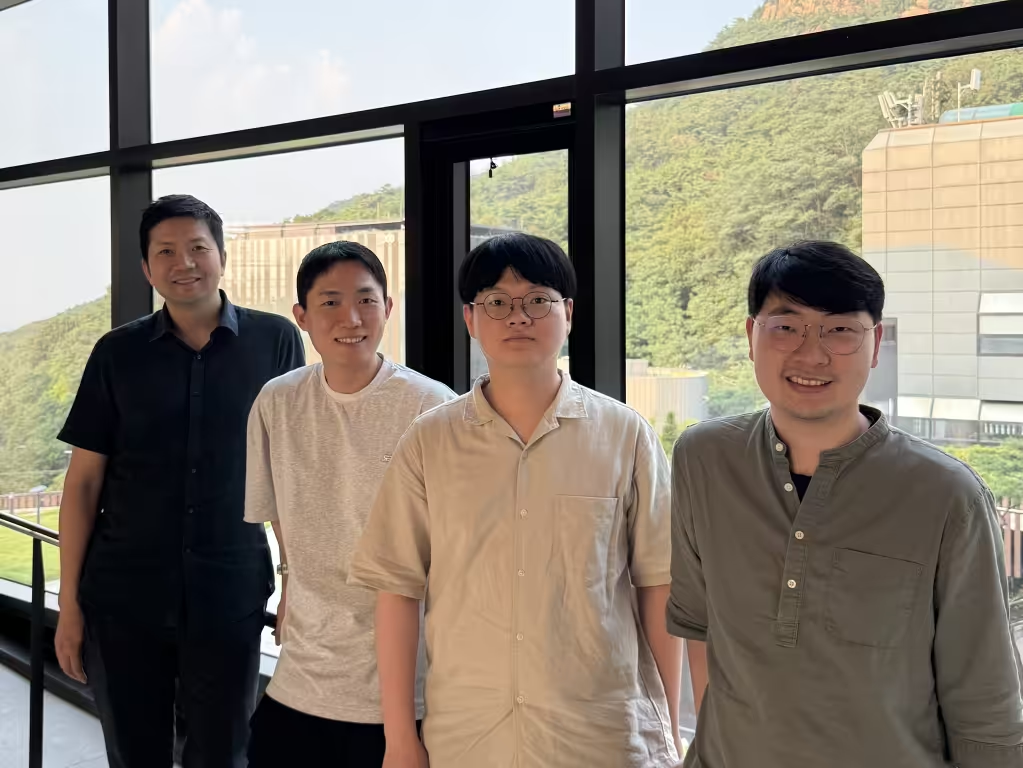

다시점 확산 모델을 후속 학습하여, 역동적인 사람의 자세에서도 자연스러운 다시점 영상을 생성하도록 개선하는 핵심 아이디어 제안 후속 학습된 다시점 확산 모델을 단일 영상 기반 3D 인간 복원 파이프라인에 통합하여, 동적인 포즈를 취한 사람을 보다 자연스럽게 3D로 복원하는 방법 개발. 3D 인간 복원 벤치마크에서 기존 최고성능 기술 대비 개선된 성능 입증박재식 교수 연구진(도승욱, 허민우, 신중혁, 박재식) 이 단일 영상으로부터 복잡한 자세를 취한 사람을 3D 복원하는 기술을 개발하였다. 다시점 확산 모델(multi-view diffusion model)을 활용한 3D 인간 모델링은 세밀한 디테일까지 잘 복원할 수 있는 효과적인 접근법이다. 그러나 기존 기술은 학습 데이터셋의 규모가 제한적이어서, 역동적이고 난이도 높은 자세를 보이는 사람의 영상으로부터 3D 복원을 수행할 때 결과물의 정확도가 떨어지고 자세가 부자연스러운 문제가 있었다. 이를 해결하기 위해, 한 장의 영상과 인체 자세의 쌍이 주어졌을 때 다시점 확산 모델이 생성한 영상과 인체 자세간의 정합도(alignment)를 계산하는 미분 가능한 보상 모델(reward model)을 제안하고, 이를 활용한 후속 학습 알고리즘인 DrPose를 개발하였다. DrPose로 학습된 다시점 확산 모델 기반 3D 인간 복원 기법은 기존 최고 수준 방법 대비 다양한 상황에서 더 자연스럽고 정확한 포즈를 복원하는 것으로 나타났다. 기존 벤치마크뿐만 아니라, 난이도 높은 자세의 평가를 위해 새롭게 제시된 벤치마크(MixamoRP)에서도 기존 기술을 능가하는 것을 실험적으로 입증하였다. 본 연구는 인공지능 분야 최우수 학술대회 중 하나인 ICLR 2026에 채택되어 오는 4월 중 발표될 예정이며, 이 논문을 포함하여 박재식 교수 연구실에서는 총 3편의 논문을 ICLR 2026에 발표할 예정이다.Direct Reward Fine-Tuning on Poses for Single Image to 3D Human in the Wild, Seunguk Do, Minwoo Huh, Joonghyuk Shin, Jaesik Park, International Conference on Learning Representations (ICLR), 2026....