배준익 학생, NeurIPS 2025 PokéAgent 챌린지 스피드런 트랙 우승

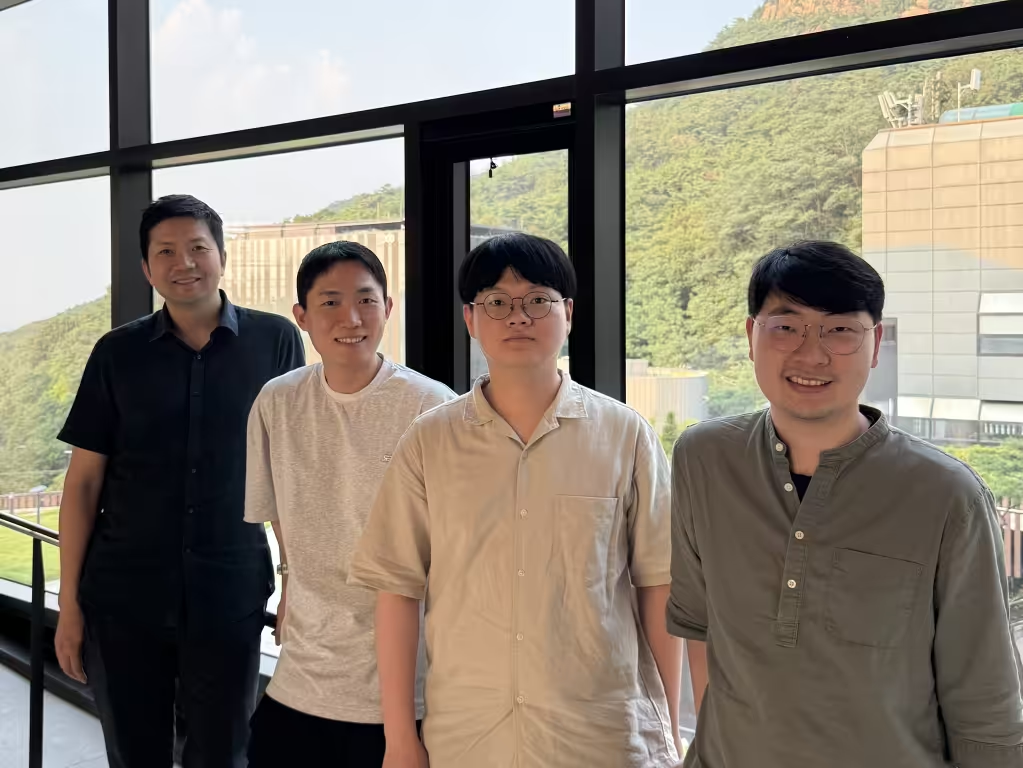

세계적인 인공지능 학회 NeurIPS 2025에서 열린 포켓몬 게임 기반 AI 대회인 PokéAgent 챌린지에서, 본교 컴퓨터공학부 4학년 배준익 학생이 스피드런(speedrun) 트랙 우승을 차지했다. 이번 챌린지는 포켓몬 에메랄드 환경을 기반으로 강화학습(RL)과 대형 언어 모델(LLM)을 결합한 새로운 형태의 에이전트를 평가하기 위해 설계되었다. 스폰서로는 구글 DeepMind가 참여했으며, Princeton, CMU, UT Austin 등 주요 연구 기관의 연구진이 공동으로 대회를 기획했다. 총 상금 규모는 1만 5천 달러를 상회하며, 우승팀에게는 NeurIPS 워크숍 발표 초청과 대회 보고서 공동 저자 참여 기회 등이 제공된다.스피드런 트랙은 에이전트가 포켓몬 에메랄드를 가능한 한 빠르게 엔딩까지 진행하도록 설계된 과제로, 부분 관측(partial observability) 환경에서 수천 타임스텝에 걸쳐 일관된 전략을 유지해야 하는 long-horizon planning 문제라는 점이 특징이다. 배준익 학생이 개발한 에이전트는 약 40분 만에 게임을 완주해, 약 70분을 기록한 2위 팀을 큰 격차로 앞서며 스피드런 트랙 1위를 기록했다.우승 에이전트의 핵심은 LLM 기반 코드 생성(code generation)을 활용한 계층적 계획 방식에 있다. 먼저 LLM이 주어진 장기 목표를 여러 하위 목표(subgoal)로 자동 분해하고, 각 하위 목표를 처리하기 위한 파이썬 코드 형태의 루틴을 생성한다. 이렇게 생성된 코드 루틴은 에이전트가 어떤 상태에서 어떤 행동을 택해야 할지에 대한 구조화된 힌트나 보상 신호 역할을 하며, 강화학습이 더 빠르고 안정적으로 수렴하도록 돕는다. 계획이 코드로 남기 때문에 사람이 에이전트의 의사결정 과정을 추적하고 수정하기에도 비교적 수월하다는 장점이 있다.배준익 학생은 이번에 개발한 LLM+RL 하이브리드 에이전트를 샌드박스형 시뮬레이션 게임 등 다른 복잡한 환경으로 확장해 실험할 계획이다. 나아가 로보틱스와 같이 복잡한 장기 의사결정이 요구되는 분야로 응용 범위를 넓히는 후속 연구도 추진할 예정이다. 본 연구는 연세대학교 이영운 교수와 서울대학교 박재식 교수의 지도 하에 컴퓨터공학부 학부 졸업논문으로 정리될 계획이다....